前回の記事では、一般的なWindowsPCでStableDiffusionを簡単に動作させる方法を紹介しました。

本記事ではモデルを変えることで画像生成のクオリティを大幅に引き上げる方法を紹介します。

1.モデルとは

画像生成では、事前に大量の画像で学習された「モデル」を使用します。

例えば、油絵風のイラストを大量に学習したモデルでは油絵風の画像を生成するのが得意になり、

美しい女性を大量に学習したモデルでは美しい女性を生成するのが得意になります。

モデルは多種多様なものがリリースされているため上手に活用することで高いクオリティの画像が生成できます。

2.モデルのダウンロード

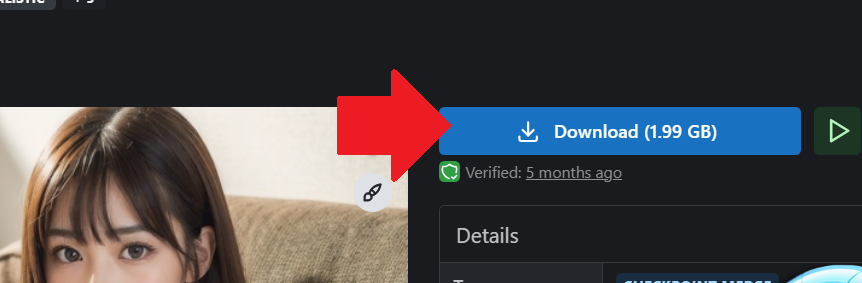

試しに「yayoi_mix」というリアル系AI美女の生成に特化したモデルを設定してみます。

リンクで「yayoi_mix」と検索してモデルのページに遷移します。

右側にあるDownloadをクリックするとモデルのファイルがダウンロードできます。

※サイズが大きいためダウンロード完了には時間がかかります。

3.Stable Diffusion Web UI にモデル追加

ダウンロードが完了したら前回の記事で作成した[stable-diffusion-webui]フォルダ内の

[stable-diffusion-webui]>[models]>[Stable-diffusion]のフォルダに、ダウンロードしたモデルファイルを格納します。

これで追加は完了です。

4.Stable Diffusion Web UI で画像生成

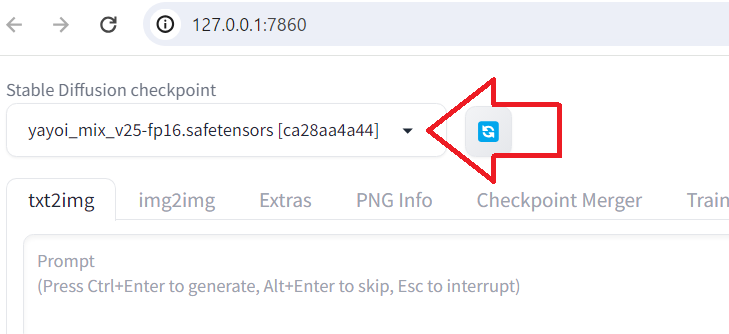

前回の記事同様に[webui-user.bat]のファイルをダブルクリックして起動します。

左上の「Stable Diffusion checkpoint」をクリックしてyayoi_mixと名前のついたモデルを選択します。

あとは自由に画像生成するだけです。大幅にクオリティがアップした画像を生成できます。

Positive prompt

8k, RAW photo, best quality, masterpiece, realistic, photo-realistic, clear, professional lighting, beautiful face, best quality,ultra high res

BREAK

realistic Japanese cute, girl, 18 years old,

short hair, smile,

Negative prompt

EasyNegative, deformed mutated disfigured, missing arms, 4 fingers, 6 fingers, extra_arms , mutated hands, bad anatomy, disconnected limbs, low quality, worst quality, out of focus, ugly, error, blurry, bokeh, Shoulder bag, bag, multiple arms, nsfw.

5.【おまけ】Stable Diffusion Web UI でVAEを設定

下記に従ってVAEを同様に設定しておくと画質が向上するようです。

【比較検証】Stable Diffusionの『VAE』とは?使い方やおすすめVAEも紹介 | romptn Magazine

まとめ

Stable Diffusionでモデルを変えることで画像生成のクオリティを大幅に引き上げる方法を紹介しました。

今回は「yayoi_mix」というモデルを試してみましたが是非いろいろなモデルで遊んでみてください。